新型⼈⼯智能⼯具允许艺术创作者掩盖个⼈⻛格以防⽌被⼈⼯智能公司抓取

打开文本图片集

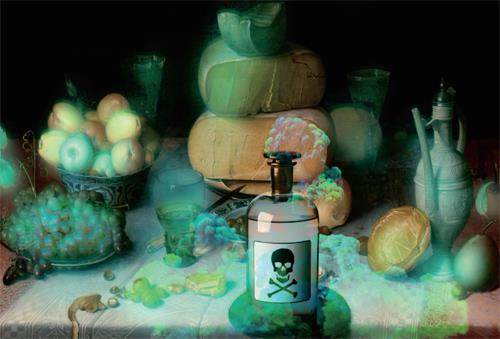

一种新工具可以让艺术家在他们的作品中添加不可见的像素变化,如果作品上传到网上,并被抓取到人工智能模型的训练集中,它可能会导致最终模型以混乱和不可预测的方式崩溃。

这款名为Nightshade的工具旨在反击人工智能公司,这些公司在未经创作者许可的情况下使用他们的作品来训练模型。

使用它来“毒害”这些训练数据,可能会破坏图像生成人工智能模型未来的迭代,包括DALL-E、Midjourney和StableDiffusion等知名工具,其破坏方式是将模型的输出变得无用,例如将狗变成猫,汽车变成牛等等。(剩余2220字)

网站仅支持在线阅读(不支持PDF下载),如需保存文章,可以选择【打印】保存。